L’applicazione di un efficace modello di pensiero laterale nel problem solving e nella gestione del rischio, è la base per ottenere risultati efficaci.

Ma il problema è proprio trovare il modello migliore sfuggendo alle insidie insite proprio nella nostra rappresentazione e valutazione della realtà che ci circonda.

Quando ragioniamo sui problemi e sui rischi, nella maggior parte dei casi compiamo il primo errore: prevediamo il futuro sulla scorta degli avvenimenti passati e sull’osservazione del presente.

Il campo del visibile, sommato all’esperienza, ci danno l’illusione di aver costruito una mappa sensata della realtà.

Purtroppo i rischi e le soluzioni dei problemi si trovano spesso in territori che stanno “fuori” dalla nostra esperienza e quindi dalla nostra capacità previsionale o di individuare soluzioni efficaci.

Infatti sono almeno due i pericoli più consistenti, ed entrambi sono legati a precisi auto-inganni della mente: il primo genera una previsione di rischio incompleta (prevedo difficoltà e problemi futuri sulla base delle mie conoscenze attuali e della mia esperienza. Poiché una cosa non è mai accaduta mi rassicuro sul fatto che non potrà mai accadere).

Il secondo riguarda la ricerca della soluzione: mi baso sugli elementi di realtà di cui dispongo per elaborare soluzioni che partono proprio dall’interno di quel problema e dai dati che lo costituiscono: ovvero, stando con i piedi dentro un secchio cerco di sollevarmi da terra tirando il secchio per il manico.

Ma cosa c’entrano gli aerei e i cigni neri?

Si tratta di due esempi che spiegano perfettamente questi due concetti.

La rottura delle convinzioni pregresse alla luce di un accadimento imprevisto e impensabile è raccontata da Nassim Nicholas Taleb nel suo libro “Il cigno nero. Come l’improbabile governa la nostra vita“: fino all’arrivo degli europei in Australia nessuno di loro poteva prevedere che esistessero in natura cigni neri.

L’evidenza dei soli cigni bianchi ne escludeva la possibilità (e in effetti si credeva che non esistessero). Una volta scoperti, a posteriori, si è spiegato che, in effetti, nessuna legge biologica o naturale si opponeva alla loro esistenza: una convinzione di millenni spazzata via dal semplice allargamento del “campo visivo”.

La storia di Abraham Wald, invece, spiega bene la necessità di applicare soluzioni contro intuitive e inedite a problemi che si generano in contesti dove l’evidenza della realtà sia incompleta e quindi dove sia più probabile la tentazione di chi analizza di “completare il quadro” con elementi mutuati dalla propria visione parziale o esperienziale.

Wald, esperto di statistica ungherese, durante la Seconda Guerra Mondiale fu chiamato dal Governo britannico ad analizzare i danni inferti dalla Luftwaffe e dalla contraerea agli aerei della RAF.

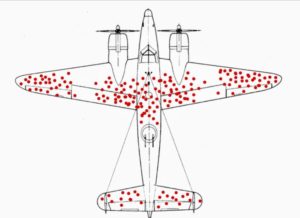

L’obiettivo era comprendere dove rinforzare le protezioni degli aerei per renderli meno vulnerabili senza appesantirli troppo. Wald osservò e catalogò i colpi sulle carlinghe di moltissimi aerei al ritorno delle varie missioni, mappandoli su una rappresentazione generica dell’aereo, e giunse a una conclusione che lasciò tutti a bocca aperta (ma che si rivelò poi vincente).

Nell’immagine è possibile vedere la mappatura dei colpi rappresentati dai punti rossi: la soluzione suggerita da Wald fu di rafforzare le parti bianche. Perché?

L’analisi dei colpi su aerei rientrati dalle missioni era possibile proprio perché quei colpi non ne avevano causato l’abbattimento, se ne poteva dedurre, quindi, che quelli non rientrati erano stati colpiti nelle parti bianche dello schema.

Rimuovendo la naturale tentazione a pensare di rafforzare quelle parti che erano state maggiormente colpite e invertendo il pensiero, si è giunti alla soluzione corretta.